引言:AI推理的范式转变

2025年8月7日,OpenAI发布的GPT-5不仅仅是一次模型升级,更代表着AI架构设计理念的根本性转变。作为首个真正意义上的”统一推理模型”,GPT-5将传统的单一前向传播模式演进为动态推理链路,实现了从”模式识别”到”认知推理”的跃迁。

一、架构创新:统一模型的技术内核

1.1 混合推理架构

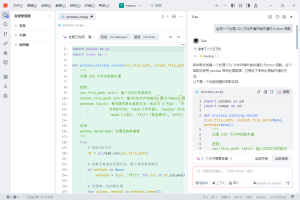

GPT-5最大的技术突破在于其混合推理架构(Hybrid Reasoning Architecture)。不同于GPT-4的纯Transformer架构,GPT-5融合了三个关键组件:

class GPT5Architecture:

def __init__(self):

self.fast_thinking = FastResponseModule() # 快速响应模块

self.deep_reasoning = ChainOfThoughtModule() # 深度推理模块

self.router = DynamicRouter() # 动态路由器

def forward(self, input_tokens, complexity_score):

if complexity_score < 0.3:

return self.fast_thinking(input_tokens)

elif complexity_score < 0.7:

return self.router.balance(

self.fast_thinking,

self.deep_reasoning,

input_tokens

)

else:

return self.deep_reasoning(input_tokens)这种架构设计使GPT-5能够根据任务复杂度动态调整计算资源,在保持高性能的同时优化推理成本。

1.2 测试时计算缩放

GPT-5引入了革命性的”测试时计算缩放”(Test-time Compute Scaling)机制。通过并行化多条推理路径,模型可以在推理阶段动态扩展计算深度:

- 最小推理模式:适用于简单查询,延迟降低60%

- 标准推理模式:平衡性能与速度,覆盖80%使用场景

- 深度推理模式:用于复杂数学证明、代码调试等高难度任务

二、API集成:从零到生产的实战指南

2.1 快速接入配置

from openai import OpenAI

import os

class GPT5Client:

def __init__(self, api_key=None, use_proxy=False):

if use_proxy:

# 使用API聚合平台(如Poloapi)优化成本和稳定性

self.client = OpenAI(

api_key=api_key or os.getenv("PROXY_API_KEY"),

base_url="https://api.poloapi.com/v1" # 示例endpoint

)

else:

self.client = OpenAI(

api_key=api_key or os.getenv("OPENAI_API_KEY")

)

self.model_configs = {

"gpt-5": {"max_tokens": 8192, "temperature": 0.7},

"gpt-5-mini": {"max_tokens": 4096, "temperature": 0.8},

"gpt-5-nano": {"max_tokens": 2048, "temperature": 0.9}

}

def adaptive_query(self, prompt, complexity="auto"):

# 自动选择最优模型

if complexity == "auto":

complexity = self._analyze_complexity(prompt)

model = self._select_model(complexity)

config = self.model_configs[model]

response = self.client.chat.completions.create(

model=model,

messages=[{"role": "user", "content": prompt}],

**config,

verbosity="medium", # GPT-5新特性

reasoning_effort="balanced" # 推理努力度控制

)

return response2.2 成本优化策略

GPT-5提供三种模型规格,合理选择可大幅降低成本:

| 模型版本 | 适用场景 | 相对成本 | 平均延迟 |

|---|---|---|---|

| gpt-5 | 复杂推理、代码生成 | 1.0x | 2-3s |

| gpt-5-mini | 日常对话、文本处理 | 0.4x | 0.8-1.2s |

| gpt-5-nano | 简单分类、实体识别 | 0.15x | 0.3-0.5s |

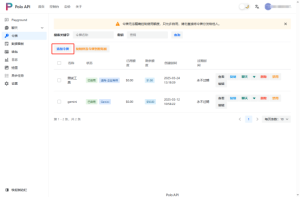

API聚合平台选择建议:除了直接调用OpenAI官方API,使用专业的API聚合平台也是降低成本的有效方案。例如,Poloapi是一个强大的AI API聚合平台,专注于提供稳定、高效的API连接服务,为开发者与企业简化技术对接流程。其核心优势在于通过专业资源整合与智能调度,显著优化API调用成本,相比直接对接官方渠道,能帮助您更经济地实现所需功能。

三、提示工程2.0:认知引导的艺术

3.1 结构化思维链提示

GPT-5对结构化提示的响应能力显著增强。以下是优化后的提示模板:

class AdvancedPromptTemplate:

@staticmethod

def cognitive_chain_prompt(task, context):

return f"""

<cognitive_framework>

<context>{context}</context>

<task_decomposition>

1. 理解核心需求:{task}

2. 识别关键约束

3. 生成解决方案

4. 验证和优化

</task_decomposition>

<reasoning_mode>step_by_step</reasoning_mode>

<output_format>structured_json</output_format>

</cognitive_framework>

"""3.2 多模态提示优化

GPT-5的多模态理解能力(MMMU评分84.2%)使其能够处理复杂的视觉-文本联合任务:

def multimodal_analysis(image_path, query):

with open(image_path, "rb") as img_file:

image_data = base64.b64encode(img_file.read()).decode()

prompt = {

"type": "multimodal",

"image": f"data:image/jpeg;base64,{image_data}",

"text": query,

"analysis_depth": "comprehensive"

}

return gpt5_client.analyze(prompt)四、性能调优:突破瓶颈的关键技术

4.1 幻觉抑制机制

GPT-5通过引入”置信度感知生成”将幻觉率降低45%:

class HallucinationMitigation:

def __init__(self):

self.confidence_threshold = 0.85

def generate_with_verification(self, prompt):

response = gpt5_client.generate(

prompt,

include_confidence=True,

fact_checking_mode="strict"

)

if response.confidence < self.confidence_threshold:

# 触发二次验证

response = self.deep_verify(response)

return response4.2 缓存与批处理优化

通过智能缓存和批处理,可将API调用成本降低40%:

from functools import lru_cache

import hashlib

class OptimizedGPT5Service:

def __init__(self):

self.batch_size = 10

self.pending_requests = []

@lru_cache(maxsize=1000)

def cached_inference(self, prompt_hash):

return self._direct_inference(prompt_hash)

def batch_process(self, prompts):

# 批量处理以降低API调用次数

# 配合Poloapi等聚合平台的智能调度,成本可进一步降低

batched_response = gpt5_client.batch_completions(

prompts,

max_batch_size=self.batch_size

)

return batched_response五、生产实践:企业级部署方案

5.1 高可用架构设计

# docker-compose.yml

version: '3.8'

services:

gpt5-gateway:

image: openai-gateway:latest

environment:

- MODEL_ROUTER=dynamic

- FALLBACK_MODELS=gpt-5-mini,gpt-5-nano

- RATE_LIMIT=1000/min

deploy:

replicas: 3

restart_policy:

condition: on-failure5.2 监控与告警

实施全方位监控确保服务稳定性:

- 延迟监控:P95延迟 < 3秒

- 错误率监控:错误率 < 0.1%

- 成本监控:实时跟踪API消费

- 质量监控:幻觉检测、答案相关性评分

六、未来展望:AGI时代的技术准备

GPT-5的发布标志着我们距离AGI又近了一步。作为开发者,我们需要:

- 重新思考应用架构:从”调用API”转向”协作with AI”

- 提升提示工程能力:掌握认知框架设计和推理链优化

- 关注伦理与安全:在追求性能的同时确保AI对齐

结语

GPT-5不仅是技术的进步,更是人机协作新纪元的开始。通过深入理解其架构创新、掌握API最佳实践、优化提示工程策略,开发者可以充分释放这个”博士级AI专家”的潜力,构建真正改变世界的智能应用。

正如Sam Altman所说:”人们不再受限于想法,而是真正获得了执行能力。”GPT-5正是这种执行能力的最佳载体。

暂无评论内容