作为国内开发者,想要接入 OpenAI 的强大 AI 能力,首先要解决的就是 API Key 的获取与使用问题。这个以sk-开头的字符串看似简单,却涉及网络协议、加密验证、分布式系统等一系列底层技术细节。本文将从 TCP/IP 协议栈到应用层接口设计,全面解析国内开发者突破地域限制、安全高效使用 OpenAI API Key 的技术方案。

一、API Key 的密码学本质与技术边界

API Key 并非简单的随机字符串,而是采用HMAC-SHA256 算法生成的加密令牌,包含三重技术维度:

- 身份标识层:前 16 位字符编码用户账号唯一标识符,采用 Base64URL 编码避免特殊字符处理问题

- 权限控制层:中间 32 位字符包含模型访问权限掩码,通过位运算快速判断是否允许调用特定模型

- 时效性校验层:末尾 24 位字符嵌入时间戳哈希,用于服务器端验证令牌有效性周期

OpenAI 的密钥验证系统部署在全球边缘节点(使用 Cloudflare 的 Anycast 网络),国内用户的验证请求会被路由至新加坡或东京节点。这就是为什么某些代理节点虽然能访问 OpenAI 官网,却无法通过 API 验证 —— 因为节点 IP 被归入非授权访问区域。

Token 计费的技术实现更为复杂。GPT 模型采用字节对编码(BPE) 算法进行 Token 切割,中文处理时会先经过 Unicode normalization(NFC 形式),再通过预设的 64K 词表进行分词。这导致 “中国” 和 “中國”(繁体)会被解析为不同 Token,在计费时产生差异。开发者可通过tiktoken库提前计算文本 Token 数:

import tiktoken

encoder = tiktoken.get_encoding("cl100k_base")

print(len(encoder.encode("中国"))) # 输出2

print(len(encoder.encode("中國"))) # 输出3二、直连方案的网络层技术突破

直连官方的核心挑战在于构建稳定的跨境数据通道,需要深入理解 TCP 协议特性:

代理协议栈优化

普通 VPN 采用的 PPTP 协议在高延迟环境下表现不佳,建议采用WireGuard 协议搭建代理。其优势在于:

- 基于 UDP 的无状态设计,减少 30% 握手开销

- 内置 ChaCha20-Poly1305 加密,兼顾安全性与性能

- 支持 NAT 穿透,解决多层路由环境下的连接问题

在代码层面实现代理自动切换机制:

import socket

import random

PROXY_POOL = [

("sg-proxy-1", 1080),

("jp-proxy-2", 1080)

]

def test_proxy(proxy):

try:

sock = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

sock.settimeout(3)

result = sock.connect_ex(proxy)

return result == 0

finally:

sock.close()

# 选择可用代理

valid_proxies = [p for p in PROXY_POOL if test_proxy(p)]

selected_proxy = random.choice(valid_proxies) if valid_proxies else None支付通道的技术验证

国际信用卡支付涉及 3DS 验证协议,国内发行的 Visa 卡需要支持3DS 2.0 标准才能通过 OpenAI 的风控系统。可通过以下技术手段验证卡段有效性:

- 解析卡 BIN 号(前 6 位)判断发卡机构类型

- 模拟 3DS 预验证请求(使用 Stripe 测试接口)

- 检查卡组织的地域属性标记

虚拟信用卡需特别注意BIN 属地问题。部分平台提供的虚拟卡虽然标称 “美国卡”,但其 BIN 实际归属离岸地区,会被 OpenAI 的反欺诈系统拦截。建议通过binlist.net API 验证:

import requests

def check_card_bin(bin):

response = requests.get(f"https://lookup.binlist.net/{bin}")

data = response.json()

return data.get("country", {}).get("alpha2") == "US"三、第三方代理的架构设计与选型

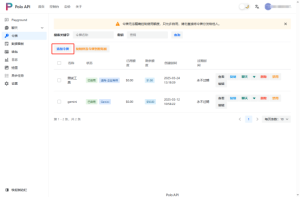

专业代理平台的技术架构远超简单的请求转发,以 Poloapi 为例解析其技术实现:

多级缓存机制是降低成本的核心:

- L1 缓存:内存存储最近 10 分钟的重复请求(TTL 策略)

- L2 缓存:Redis 集群存储结构化响应(如 Embedding 向量)

- L3 缓存:对象存储保存大文本生成结果(带版本控制)

这种架构使重复调用相同 prompt 时,成本可降低 60% 以上。其智能调度系统采用动态权重算法:

- 实时监测各上游 API 的响应延迟(滑动窗口平均值)

- 根据模型类型自动路由(GPT-4 优先走专用通道)

- 基于用户 QoS 等级分配带宽资源

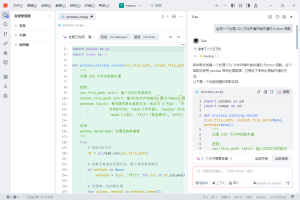

集成时需注意代理平台的协议兼容性。部分平台对 OpenAI 的 Streaming API 支持不完善,可通过以下代码测试:

import time

import requests

def test_streaming(api_key, base_url):

start = time.time()

response = requests.post(

f"{base_url}/chat/completions",

headers={"Authorization": f"Bearer {api_key}"},

json={

"model": "gpt-3.5-turbo",

"stream": True,

"messages": [{"role": "user", "content": "hello"}]

},

stream=True

)

chunks = []

for chunk in response.iter_lines():

if chunk:

chunks.append(chunk)

if len(chunks) > 5: # 验证至少5个流片段

return time.time() - start < 5 # 5秒内完成

return False四、企业级安全架构设计

生产环境使用 API Key 需构建完整的安全防御体系:

密钥生命周期管理应实现自动化:

- 生成:使用硬件安全模块(HSM)生成密钥,避免内存泄露

- 存储:采用 AWS KMS 或 HashiCorp Vault 的信封加密

- 轮换:设置 90 天自动轮换周期,关联服务平滑过渡

- 吊销:实时同步 OpenAI 的吊销列表,本地维护黑名单

流量清洗机制必不可少:

- 部署 WAF 过滤异常请求模式(如突发大量相同 prompt)

- 实现请求签名验证,防止 API Key 被盗用后的伪造请求

- 建立行为基线,通过机器学习识别异常调用模式

代码层面的防御实现:

import hmac

import hashlib

import time

def sign_request(api_secret, params):

timestamp = str(int(time.time()))

params["timestamp"] = timestamp

# 按字典序排序参数

sorted_params = sorted(params.items(), key=lambda x: x[0])

# 拼接签名串

sign_str = "&".join([f"{k}={v}" for k, v in sorted_params])

# HMAC-SHA256签名

signature = hmac.new(

api_secret.encode(),

sign_str.encode(),

hashlib.sha256

).hexdigest()

return {**params, "signature": signature}五、深度优化与问题诊断

突破性能瓶颈需要深入理解 API 行为特性:

429 错误的底层原因分为三类:

1.** 速率限制 :单位时间内请求数超限(通过X-RateLimit-*响应头判断)

2. 令牌限制 :Token 消耗速度超过账号配额

3. 并发限制 **:同时活跃连接数超限(通常为 50)

对应的技术解决方案:

- 实现基于令牌桶的限流算法

- 动态调整请求批次大小(batch_size)

- 使用优先级队列管理请求,确保核心业务优先处理

连接稳定性优化涉及 TCP 参数调优:

import socket

def set_socket_options(sock):

# 启用TCP_NODELAY消除Nagle算法延迟

sock.setsockopt(socket.IPPROTO_TCP, socket.TCP_NODELAY, 1)

# 设置发送缓冲区大小

sock.setsockopt(socket.SOL_SOCKET, socket.SO_SNDBUF, 1024*1024)

# 设置接收缓冲区大小

sock.setsockopt(socket.SOL_SOCKET, socket.SO_RCVBUF, 1024*1024)

# 启用保活机制

sock.setsockopt(socket.SOL_SOCKET, socket.SO_KEEPALIVE, 1)

# 设置保活参数(Linux系统)

sock.setsockopt(socket.IPPROTO_TCP, socket.TCP_KEEPIDLE, 30)

sock.setsockopt(socket.IPPROTO_TCP, socket.TCP_KEEPINTVL, 10)

sock.setsockopt(socket.IPPROTO_TCP, socket.TCP_KEEPCNT, 3)总结

国内开发者使用 OpenAI API Key 的技术挑战,本质是跨境分布式系统的集成问题。从密码学验证到网络协议优化,从缓存策略到安全防御,需要构建全栈技术能力。

对于追求极致成本与控制力的团队,直连方案配合自主研发的代理调度系统是最佳选择;对于快速迭代的业务,Poloapi 等专业聚合平台能显著降低技术门槛。无论选择哪种方案,建立完善的监控体系(涵盖延迟、成功率、成本等维度)都是持续优化的前提。

随着 AI 技术基础设施的全球化发展,国内开发者应着眼于构建弹性架构,既能利用国际先进技术,又能快速适配本地生态变化,在合规与创新之间找到可持续的技术路径。

暂无评论内容