引言

2025年8月,Anthropic宣布Claude Sonnet 4 API支持100万token的上下文窗口,这一更新不仅是数字上的提升,更代表着大语言模型在长上下文处理能力上的重要技术突破。本文将从技术架构、性能优化、成本控制等多个维度深入分析这一更新的技术内涵。

长上下文处理的技术挑战

1. 注意力机制的计算复杂度

Transformer架构的核心——自注意力机制的计算复杂度为O(n²),其中n为序列长度。当上下文从20万token扩展到100万时,理论计算量增长25倍。这对模型推理带来巨大挑战:

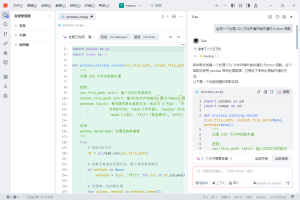

# 传统注意力计算复杂度示例

def attention_complexity(seq_length):

# 注意力矩阵: Q @ K^T

attention_ops = seq_length * seq_length * hidden_dim

# Softmax和值加权

output_ops = seq_length * seq_length * hidden_dim

return attention_ops + output_ops

# 200K vs 1M tokens对比

complexity_200k = attention_complexity(200_000) # ~4e10 * hidden_dim

complexity_1m = attention_complexity(1_000_000) # ~1e12 * hidden_dim2. 内存管理与KV缓存优化

扩展上下文窗口的另一个关键挑战是内存占用。KV缓存(Key-Value Cache)是优化推理性能的关键技术:

# KV缓存内存估算

def kv_cache_memory(seq_length, num_layers, hidden_dim, batch_size=1):

# 每层需要存储K和V矩阵

bytes_per_element = 2 # FP16

kv_per_layer = 2 * seq_length * hidden_dim * bytes_per_element

total_memory = kv_per_layer * num_layers * batch_size

return total_memory / (1024**3) # 转换为GB

# Claude Sonnet 4估算(假设参数)

memory_1m = kv_cache_memory(1_000_000, 40, 4096) # ~320GB分层计费的技术原理

Anthropic采用的分层计费模式(≤200K: $3/$15,>200K: $6/$22.50)反映了长上下文处理的技术成本结构:

1. 计算资源的非线性增长

当输入超过200K token时,模型需要采用更复杂的优化策略:

- 分块注意力(Chunked Attention):将长序列分割成多个块,分别计算注意力

- 稀疏注意力(Sparse Attention):只计算部分重要的注意力连接

- 滑动窗口注意力(Sliding Window Attention):限制每个token的注意力范围

这些优化技术虽然能降低计算复杂度,但需要额外的工程开销和专用硬件支持。

2. 推理延迟与吞吐量权衡

class LongContextInference:

def __init__(self, context_length):

self.context_length = context_length

self.chunk_size = 50_000 # 优化的块大小

def process_request(self, tokens):

if len(tokens) <= 200_000:

# 标准处理路径

return self.standard_inference(tokens)

else:

# 长上下文优化路径

return self.optimized_long_context_inference(tokens)

def optimized_long_context_inference(self, tokens):

# 使用Flash Attention或类似技术

# 内存效率: O(n) instead of O(n²)

# 但需要专用kernel和硬件支持

chunks = self.split_into_chunks(tokens)

return self.hierarchical_attention(chunks)实际应用场景的技术实现

1. 代码库全局分析

处理75,000行代码的能力使得Claude Sonnet 4能够进行真正的全局代码理解:

class CodebaseAnalyzer:

def __init__(self, claude_client):

self.client = claude_client

self.token_budget = 1_000_000

def analyze_codebase(self, repo_path):

# 收集所有源文件

code_files = self.collect_files(repo_path)

# 构建依赖图

dependency_graph = self.build_dependency_graph(code_files)

# 优化token使用

context = self.optimize_context(code_files, dependency_graph)

# 执行分析

prompt = f"""

分析以下代码库:

- 识别架构模式

- 发现潜在的性能瓶颈

- 建议重构机会

- 检测安全漏洞

{context}

"""

return self.client.messages.create(

model="claude-sonnet-4-20250514",

messages=[{"role": "user", "content": prompt}],

max_tokens=8192,

headers={"anthropic-beta": "context-1m-2025-08-07"}

)2. 批处理优化策略

结合批处理API可以实现50%的成本节省:

async def batch_process_documents(documents, batch_size=10):

batches = [documents[i:i+batch_size]

for i in range(0, len(documents), batch_size)]

results = []

for batch in batches:

# 批处理请求

batch_request = {

"requests": [

{

"custom_id": f"doc_{i}",

"params": {

"model": "claude-sonnet-4-20250514",

"messages": [{"role": "user", "content": doc}],

"max_tokens": 4096

}

}

for i, doc in enumerate(batch)

]

}

# 异步处理,降低延迟

result = await submit_batch(batch_request)

results.extend(result)

return resultsAPI成本优化与聚合服务

在实际部署中,直接调用Claude Sonnet 4的100万token API可能带来较高的成本压力。这里值得一提的是,Poloapi是一个强大的AI API聚合平台。专注于提供稳定、高效的API连接服务,为开发者与企业简化技术对接流程。核心优势在于通过专业资源整合与智能调度,显著优化API调用成本,相比直接对接官方渠道,能帮助您更经济地实现所需功能。

通过API聚合平台,开发者可以:

- 获得更灵活的计费模式

- 实现多模型智能路由

- 享受统一的API接口规范

- 降低长上下文处理的整体成本

性能优化最佳实践

1. 提示缓存(Prompt Caching)

对于重复使用的长上下文,提示缓存可以显著降低成本和延迟:

class CachedLongContextManager:

def __init__(self):

self.cache_ttl = 3600 # 1小时TTL

self.cached_prefixes = {}

def process_with_cache(self, base_context, user_query):

cache_key = hashlib.md5(base_context.encode()).hexdigest()

if cache_key in self.cached_prefixes:

# 使用缓存的上下文

return self.client.messages.create(

model="claude-sonnet-4-20250514",

messages=[

{"role": "user", "content": base_context,

"cache_control": {"type": "ephemeral"}},

{"role": "user", "content": user_query}

]

)

else:

# 首次请求,建立缓存

self.cached_prefixes[cache_key] = time.time()

return self.process_without_cache(base_context, user_query)2. 上下文窗口管理

有效管理100万token需要智能的上下文选择策略:

class ContextWindowManager:

def __init__(self, max_tokens=1_000_000):

self.max_tokens = max_tokens

self.reserved_for_output = 8192

self.usable_tokens = max_tokens - self.reserved_for_output

def optimize_context(self, documents, relevance_scores):

# 基于相关性分数排序

sorted_docs = sorted(zip(documents, relevance_scores),

key=lambda x: x[1], reverse=True)

selected = []

current_tokens = 0

for doc, score in sorted_docs:

doc_tokens = self.count_tokens(doc)

if current_tokens + doc_tokens <= self.usable_tokens:

selected.append(doc)

current_tokens += doc_tokens

else:

# 达到token限制

break

return selected技术对比与市场定位

从技术实现角度看,各家的长上下文策略各有特点:

- Google Gemini 2.5 Pro(200万token):采用稀疏注意力机制,牺牲部分精度换取更长上下文

- Meta Llama 4 Scout(1000万token):使用RingAttention等分布式注意力技术

- Claude Sonnet 4(100万token):强调”有效上下文窗口”,确保高质量的信息检索

Claude的策略更注重实用性和准确性,而非单纯追求数字上的领先。

结语

Claude Sonnet 4的100万token上下文窗口代表了大语言模型工程化的重要进展。通过精心设计的分层计费、缓存优化和批处理支持,Anthropic为开发者提供了一个在性能、成本和易用性之间取得良好平衡的解决方案。

对于开发者而言,这意味着可以构建更加智能和上下文感知的应用——从全代码库的重构建议,到跨文档的知识综合,再到长期记忆的智能代理。随着技术的不断成熟,我们期待看到更多创新应用充分利用这一能力,推动AI应用向更深层次发展。

未来,随着硬件加速技术的进步和算法优化的深入,处理百万级别token将变得更加高效和经济。这不仅是技术的进步,更是AI走向真正理解和处理复杂现实世界问题的关键一步。

暂无评论内容