在人工智能飞速发展的当下,AI 创作工具不断推陈出新,为我们的创意表达开辟了全新路径。So-VITS-SVC 语音合成模型能够赋予文字灵动的声音,Stable Diffusion 文生图模型则可将文字描述转化为精美的图像,二者结合,能构建出极具创意的多媒体内容创作体系。本文将借助 GpuGeek 平台,详细讲解这两个模型的搭建过程,以及如何将它们与即梦 AI 深度融合,实现更强大的创作功能。

![图片[1]-GpuGeek 实操指南:So-VITS-SVC与Stable Diffusion详解和音画同步生成实战](https://sorry.chaofanaigc.com/wp-content/uploads/2025/07/屏幕截图-2025-07-24-145409-1024x506.png)

So-VITS-SVC 语音合成模型详解

So-VITS-SVC 是一款基于变分自编码器(VAE)和对抗生成网络(GAN)技术的开源语音合成模型。其核心优势在于能够精准捕捉并复刻人声的细微特征,包括音色、音准、节奏等,生成极为逼真的语音效果。相比早期版本,当前的 So-VITS-SVC 在性能和合成质量上实现了显著提升,如优化后的神经网络架构,大幅提高了合成速度,同时在多语言支持和韵律自然度方面也有出色表现。

模型搭建步骤

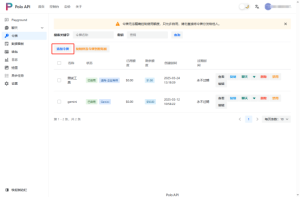

- 镜像选择:登录 GpuGeek 平台,进入镜像市场,在声音克隆分类中找到 “svc-develop-team/so-vits-svc/so-vits-svc-4.0” 镜像。该镜像集成了模型运行所需的各类依赖和基础配置,能极大简化后续搭建流程。

- 实例创建:根据自身需求选择合适的 GPU 实例规格,建议选择具有较高显存的 GPU,如 NVIDIA RTX 系列,以确保模型在训练和推理过程中的流畅运行。在创建实例时,关联上一步所选的 So-VITS-SVC 镜像,并对实例的存储、网络等参数进行合理配置。

- 环境配置与启动:实例创建完成后,通过 SSH 连接到实例终端。进入 So-VITS-SVC 项目目录,按照官方文档说明,安装必要的 Python 依赖包,如 PyTorch、NumPy、Gradio 等。完成依赖安装后,执行启动脚本,通常为 “start_webui.bat”(Windows 系统)或 “start_webui.sh”(Linux 系统),启动 Web UI 界面。

- 模型训练(可选):若要使用自定义音色进行语音合成,需进行模型训练。准备好干净、高质量的语音数据集,将其整理成规定格式后,放入指定的数据目录。在 Web UI 界面的训练配置模块中,设置好训练参数,包括数据集路径、特征提取模型、F0 音高提取器、训练轮数、批大小等,点击 “开始训练” 按钮即可开始模型训练。训练过程中,可通过 TensorBoard 实时查看训练日志,监控模型收敛情况。

- 语音合成推理:训练完成或使用预训练模型时,在 Web UI 的推理界面,选择训练好的模型权重和配置文件,上传待合成语音的文本或音频文件,调整音高、音色、语速等参数,点击 “合成” 按钮,即可快速得到合成后的语音输出,可在界面上直接试听并下载。

Stable Diffusion 文生图模型解析

Stable Diffusion 是基于潜在扩散模型(LDM)的文本到图像生成模型,通过在大规模图像数据集上进行训练,学习到文本描述与图像特征之间的映射关系,从而能够根据输入的文字描述生成相应的图像。它在创意绘画、设计概念验证、虚拟场景构建等领域应用广泛。

搭建流程

- 获取模型资源:在 GpuGeek 平台的资源库或官方渠道,下载 Stable Diffusion 的基础模型文件,通常为 “model.ckpt” 格式。此外,还可根据个人创作风格偏好,下载各类风格模型、LoRA 微调模型等扩展资源。

- 部署 Web UI:同样在 GpuGeek 平台创建 GPU 实例,选择合适的深度学习框架镜像,如包含 Python、PyTorch 和相关依赖的镜像。通过 Git 克隆 Stable Diffusion 的 Web UI 项目代码仓库到实例中,进入项目目录后,安装项目所需的依赖包,如 diffusers、transformers、gradio 等。安装完成后,运行启动脚本启动 Web UI 服务。

- 模型配置与加载:在 Web UI 界面的设置中,指定之前下载的模型文件路径,加载基础模型。若有扩展模型,也需按照相应格式和路径进行配置加载。加载完成后,模型即可准备接收文本输入进行图像生成。

- 文生图操作:在 Web UI 的文生图界面,输入详细的文本描述(正向提示词),如 “阳光明媚的海滩上,有一把彩色的遮阳伞和一把躺椅”,同时可输入反向提示词,如 “模糊、低质量、失真” 等,以排除不希望出现在生成图像中的元素。选择合适的采样方法(如 Euler a、DPM2 等,不同采样方法在生成速度和图像质量上有所差异)、采样步数、图像尺寸、CFG Scale(提示词相关性系数)等参数,点击 “生成” 按钮,模型将根据输入生成对应的图像,并在界面上展示生成结果,用户可下载保存。

So-VITS-SVC 实践部署

模型训练与微调

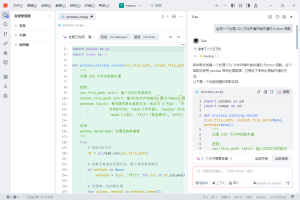

# 数据预处理

def preprocess_audio_data(audio_path, speaker_id):

import librosa

# 音频标准化

audio, sr = librosa.load(audio_path, sr=44100)

# F0提取

f0 = librosa.yin(audio, fmin=50, fmax=1100)

# 声学特征提取

mel = librosa.feature.melspectrogram(

y=audio, sr=sr, n_mels=80, n_fft=2048,

hop_length=512, win_length=2048

)

return {

'audio': audio,

'f0': f0,

'mel': mel,

'speaker_id': speaker_id

}

# 推理管道

class SoVITSInference:

def __init__(self, model_path, config_path):

self.model = self.load_model(model_path, config_path)

def voice_conversion(self, source_audio, target_speaker, f0_method="dio"):

# F0调整

f0 = self.extract_f0(source_audio, method=f0_method)

f0_adjusted = self.adjust_f0(f0, semitone_shift=0)

# 语音转换

with torch.no_grad():

converted_audio = self.model.infer(

source_audio,

target_speaker_id=target_speaker,

f0=f0_adjusted

)

return converted_audioStable Diffusion 高级应用

ControlNet集成

from diffusers import StableDiffusionControlNetPipeline, ControlNetModel

def setup_controlnet_pipeline():

# 加载ControlNet

controlnet = ControlNetModel.from_pretrained(

"lllyasviel/sd-controlnet-canny",

torch_dtype=torch.float16

)

# 构建管道

pipe = StableDiffusionControlNetPipeline.from_pretrained(

"runwayml/stable-diffusion-v1-5",

controlnet=controlnet,

torch_dtype=torch.float16,

safety_checker=None

)

return setup_model_offloading(pipe)

# 高级采样策略

def advanced_sampling(pipe, prompt, negative_prompt, steps=20):

# DPM-Solver++调度器

from diffusers import DPMSolverMultistepScheduler

pipe.scheduler = DPMSolverMultistepScheduler.from_config(

pipe.scheduler.config

)

# CFG Scale动态调整

cfg_scales = [7.5] * (steps // 2) + [5.0] * (steps - steps // 2)

return pipe(

prompt=prompt,

negative_prompt=negative_prompt,

num_inference_steps=steps,

guidance_scale_schedule=cfg_scales

)多模态融合实践

音画同步生成

class AudioVisualGenerator:

def __init__(self):

self.model_manager = ModelManager()

self.audio_analyzer = AudioAnalyzer()

def generate_synchronized_content(self, text_prompt, voice_style, visual_style):

# 阶段1:语音合成

with self.model_manager.load_model("sovits") as sovits_model:

audio_features = self.analyze_text_emotion(text_prompt)

synthesized_audio = sovits_model.generate(

text=text_prompt,

speaker_id=voice_style,

emotion_control=audio_features

)

# 阶段2:音频分析

rhythm_data = self.audio_analyzer.extract_rhythm(synthesized_audio)

emotion_curve = self.audio_analyzer.extract_emotion_curve(synthesized_audio)

# 阶段3:视觉生成

with self.model_manager.load_model("sd") as sd_pipe:

visual_prompts = self.generate_visual_prompts(

base_prompt=text_prompt,

rhythm_data=rhythm_data,

emotion_curve=emotion_curve,

style=visual_style

)

generated_frames = []

for i, prompt in enumerate(visual_prompts):

frame = sd_pipe(

prompt=prompt,

num_inference_steps=15, # 快速生成

guidance_scale=7.5

).images[0]

generated_frames.append(frame)

return synthesized_audio, generated_frames实时性能优化

# 流水线并行处理

import asyncio

from concurrent.futures import ThreadPoolExecutor

class PipelineOptimizer:

def __init__(self):

self.audio_executor = ThreadPoolExecutor(max_workers=2)

self.visual_executor = ThreadPoolExecutor(max_workers=2)

async def parallel_generation(self, requests):

audio_tasks = []

visual_tasks = []

for req in requests:

# 异步音频处理

audio_task = self.audio_executor.submit(

self.process_audio, req['audio_params']

)

# 异步视觉处理

visual_task = self.visual_executor.submit(

self.process_visual, req['visual_params']

)

audio_tasks.append(audio_task)

visual_tasks.append(visual_task)

# 等待所有任务完成

audio_results = await asyncio.gather(*[

asyncio.wrap_future(task) for task in audio_tasks

])

visual_results = await asyncio.gather(*[

asyncio.wrap_future(task) for task in visual_tasks

])

return list(zip(audio_results, visual_results))通过在 GpuGeek 平台上搭建 So-VITS-SVC 语音合成与 Stable Diffusion 文生图双模型,我们能够构建一个功能强大、创意无限的多媒体 AI 创作环境。无论是音乐创作、动画制作、广告设计还是其他创意领域,这一组合都能为创作者提供丰富的灵感和高效的创作工具,助力实现更多精彩的创意作品。希望本文的实操指南能帮助读者快速上手,开启 AI 创作的奇妙之旅。

暂无评论内容