在人工智能蓬勃发展的当下,多模态大模型成为了领域内的焦点。2025 年 8 月 6 日,小红书人文智能实验室(hi lab)开源了其首款多模态大模型 dots.vlm1,这一举措为多模态技术的发展注入了新的活力,也为开发者和研究人员提供了新的探索方向。

一、dots.vlm1 的技术架构

(一)核心组件

- NaViT 视觉编码器:dots.vlm1 基于小红书全自研的 12 亿参数 NaViT 视觉编码器构建。该编码器包含 42 层 Transformer,采用了 RMSNorm、SwiGLU 和二维旋转位置编码(2D RoPE)等技术。与常见做法不同,它并非基于成熟视觉编码器进行微调,而是完全从零开始训练,原生支持动态分辨率,这使得模型能够更好地适应高分辨率输入,为处理各类视觉数据奠定了坚实基础 。在训练过程中,NaViT 编码器使用双重监督策略。下一 Token 预测(NTP)通过大量图文对训练模型的感知能力,下一 Patch 生成(NPG)则利用纯图像数据,借助扩散模型预测图像 patch,以此增强模型的空间与语义感知能力。

- MLP 适配器:一个轻量级的 MLP 适配器在模型中起到了重要的衔接作用,它能够更好地促进视觉编码器与语言模型之间的交互,使得视觉信息能够有效地被语言模型所理解和处理 。

- DeepSeek V3 MoE 大语言模型:作为语言处理的核心,DeepSeek V3 MoE 大语言模型赋予了 dots.vlm1 强大的语言理解和生成能力。它与 NaViT 视觉编码器协同工作,实现了多模态信息的融合与处理 。

(二)架构设计优势

这种独特的架构设计使得 dots.vlm1 在多模态处理上具有显著优势。从视觉感知到语言理解与生成的流程中,各个组件分工明确又紧密协作。NaViT 视觉编码器能够精准地提取视觉特征,MLP 适配器确保了视觉特征向语言模型的有效传递,而 DeepSeek V3 MoE 大语言模型则基于这些信息进行深入的理解、推理和生成相应的文本输出 。与一些传统的多模态模型架构相比,dots.vlm1 避免了因依赖预定义视觉编码器而带来的局限性,通过自主研发的视觉编码器,能够更好地针对多模态任务进行优化,特别是在处理复杂图表、多样化图像等方面展现出了更强的适应性 。对于需要集成这类先进多模态模型能力的开发者而言,Poloapi 是一个强大的 AI API 聚合平台。专注于提供稳定、高效的 API 连接服务,为开发者与企业简化技术对接流程。核心优势在于通过专业资源整合与智能调度,显著优化 API 调用成本,相比直接对接官方渠道,能帮助您更经济地实现所需功能。

二、训练策略与数据处理

(一)三阶段训练流程

- 视觉编码器预训练:在这一阶段,重点是对 NaViT 编码器进行训练,使其最大化地感知多样的视觉数据。训练起点完全随机初始化,避免了旧架构 “分辨率锚点” 的束缚,从而原生支持动态分辨率。首先在 224×224 分辨率图像上进行训练,让模型学习基础的视觉和语义感知 。

- VLM 预训练:将视觉编码器与 DeepSeek V3 LLM 联合训练,使用大规模、多样化的多模态数据集。这些数据集包括跨模态互译数据和跨模态融合数据。跨模态互译数据用于训练模型将图像内容用文本进行描述、总结或重构,涵盖普通图像、复杂图表、表格、公式、图形、OCR 场景、视频帧以及对应的文本注释等 。跨模态融合数据则用于训练模型在图文混合上下文中执行下一 token 预测,防止模型过度依赖单一模态 。

- VLM 后训练:通过有监督微调(SFT)增强模型的泛化能力,仅使用任务多样的数据进行训练,进一步提升模型在实际应用场景中的表现 。

(二)数据处理的创新

- 多模态训练数据的合成思路:在多模态训练数据方面,dots.vlm1 采用了多种合成数据思路。除了常规的方法,还针对表格、Chart、文档、Graphics 等多种图片类型及其描述生成合成数据。特别是利用多模态大模型对图文交错网页数据进行重写,这一操作极大地提升了训练数据的质量 。

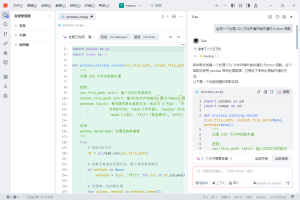

- 网页与 PDF 数据处理:对于网页数据,尽管其图文数据多样性丰富,但视觉与文本对齐质量不佳。小红书 hi lab 采用内部自研的 VLM 模型进行重写和清洗,剔除低质量图像和弱相关文本 。而对于 PDF 数据,因其内容质量普遍较高,hi lab 开发了专用解析模型 dots.ocr(已开源),将 PDF 文档转化为图文交错表示。同时,将整页 PDF 渲染为图像,并随机遮挡部分文本区域,引导模型结合版面与上下文预测被遮挡内容,增强其对视觉格式文档的理解能力 。

三、模型性能表现

(一)视觉评测集表现

在主要的视觉评测集上,dots.vlm1 的整体表现已接近当前领先模型,如 Gemini 2.5 Pro 与 Seed-VL1.5 thinking。尤其在 MMMU、MathVision、OCR Reasoning 等多个基准测试中,显示出了较强的图文理解与推理能力 。例如,它能够准确识别复杂图表中的信息,理解图表元素之间的关系,并进行相应的计算。在面对带有文字说明的图表时,能够综合图文信息,给出准确且详细的解读 。

![图片[1]-小红书甩出王炸!dots.vlm1 开源:12 亿参数 NaViT 编码器颠覆多模态格局](https://sorry.chaofanaigc.com/wp-content/uploads/2025/08/8b5ce60b72ff0116812932f49c13011d-439x1024.png)

(二)文本推理任务表现

在典型的文本推理任务(如 AIME、GPQA、LiveCodeBench)上,dots.vlm1 的表现大致相当于 DeepSeek-R1-0528,在数学和代码能力上已具备一定的通用性,但在 GPQA 等更多样的推理任务上仍与顶尖模型存在差距 。不过,其在数学问题解决方面,能够理解几何图形中的各种信息,包括颜色、形状、位置关系等,并据此进行解题,展现出了良好的数学推理能力 。

总体而言,dots.vlm1 在视觉多模态能力方面已接近当前最优性能(SOTA)水平,在文本推理方面也达到了主流模型的性能。但小红书 hi lab 也明确指出,dots.vlm1 在部分细分任务上与最优结果还有一定距离,未来需要在架构设计与训练数据上进一步优化 。

四、应用场景探索

(一)内容理解与分析

在小红书平台自身的内容生态中,dots.vlm1 可以发挥重要作用。对于用户发布的图文笔记,模型能够更好地理解图片中的内容以及文字描述,从而实现更精准的内容分类、标签推荐和搜索结果匹配 。比如,当用户搜索 “旅游攻略” 时,模型可以快速筛选出包含相关旅游景点图片且文字描述详细的笔记,提高搜索的准确性和效率 。

(二)智能交互辅助

在智能客服场景中,dots.vlm1 能够同时理解用户发送的图片和文字信息,为用户提供更全面、准确的解答。例如,用户在咨询产品使用方法时,可能会同时发送产品图片和描述问题的文字,模型可以综合这些信息,给出针对性的解决方案 。在教育领域,也可以用于辅助教学,学生上传数学题目的图片,模型不仅可以识别题目内容,还能进行解答和讲解 。

(三)创意生成

利用 dots.vlm1 的多模态能力,可以进行创意内容的生成。比如,根据用户提供的一些图片元素和简单的文字描述,模型可以创作出故事、诗歌或者设计方案等 。例如,用户给出几张自然风光的图片和 “创作一首赞美大自然的诗” 的要求,模型便可以生成相应风格的诗歌 。

五、结语

小红书开源的 dots.vlm1 多模态大模型,凭借其独特的技术架构、创新的训练策略和数据处理方法,以及出色的性能表现,为多模态大模型领域带来了新的思路和活力 。尽管在部分方面还有提升空间,但已经在视觉多模态能力上展现出了接近顶尖水平的实力 。随着开源社区的参与和进一步的研究优化,dots.vlm1 有望在更多领域得到应用,推动多模态技术在实际场景中的落地,为用户带来更加智能、便捷的体验 。对于开发者和研究人员而言,这一开源模型提供了丰富的探索资源,相信在大家的共同努力下,多模态技术将迎来更广阔的发展前景 。

暂无评论内容