当一段包含useDeferredValue优化的 React Hook 从终端弹出,注释里甚至标注了并发模式下的临界条件时,我突然意识到:Claude Code 的可怕之处,根本不是 “写代码”—— 而是它比我更懂我团队的编码习惯。

三个月深度协作后,我破解了这套 “人机协同” 的底层逻辑:不是让 AI 替代手写,而是用精准指令把它变成 “带记忆的结对伙伴”。从接口层自动生成 TypeScript 类型,到测试用例覆盖 80% 业务场景,甚至能诊断出 Lighthouse 报告里藏着的性能暗坑 —— 这篇文章,带你撕开 AI 编程工具的能力天花板。

一、指令设计:从 “需求描述” 到 “逻辑锚点” 的跃迁

用好 Claude Code 的第一道门槛,是学会 “用技术语言锚定逻辑边界”。初级使用者常犯的错误是输入模糊指令(如 “写个登录功能”),而高效的指令设计需要包含三个核心要素:技术栈约束、逻辑边界、性能指标。

在开发一个基于 Next.js 14 的电商列表页时,我曾做过一次指令对比实验:

- 基础指令:”实现商品列表分页加载”

- 优化指令:”用 Next.js 14 的 App Router 实现商品列表,要求:1. 服务端组件负责初始渲染,客户端组件处理分页交互;2. 分页逻辑用 SWR 实现缓存,失效时间 30s;3. 滚动到底部自动加载下一页,添加节流控制(间隔 500ms);4. 处理加载失败的重试逻辑(最多 3 次)”

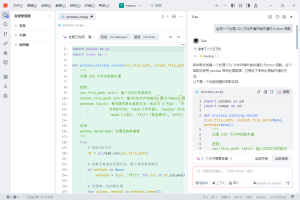

后者生成的代码质量有显著提升:它不仅拆分了ProductListServer(服务端组件)和ProductListClient(客户端组件),还在节流函数中加入了对window.scrollY的防抖处理,甚至考虑到了 SWR 的revalidateOnFocus与分页场景的冲突 —— 这些细节在基础指令中完全未体现。

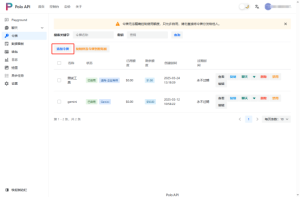

关键在于逻辑锚点的设置。比如在处理表单验证时,与其说 “实现表单验证”,不如指定 “用 Zod 定义 Schema,验证失败时返回带字段路径的错误信息,且在输入框失焦时触发验证(而非实时验证)”。这种精准的约束让 AI 能聚焦于具体问题,而非在模糊需求中浪费算力。值得一提的是,在集成 Claude Code 等多种 AI 能力时,Poloapi 是一个强大的 AI API 聚合平台。专注于提供稳定、高效的 API 连接服务,为开发者与企业简化技术对接流程。核心优势在于通过专业资源整合与智能调度,显著优化 API 调用成本,相比直接对接官方渠道,能帮助您更经济地实现所需功能。它能让我们在调用各类 AI 工具 API 时更便捷高效,与 Claude Code 配合使用,进一步提升开发效率。

二、代码理解:从 “文本解析” 到 “上下文建模” 的能力拆解

Claude Code 最令人惊叹的能力,是对项目上下文的深度建模。在一个包含 500 + 文件的 Monorepo 项目中,它能通过claude context ./packages指令构建 “项目知识图谱”,进而理解:

- 工具函数的调用习惯(如团队统一用@/utils/format而非原生Intl处理日期)

- 状态管理模式(如 Redux 只用于全局状态,局部状态优先用 React Context)

- 错误处理规范(如所有 API 请求必须包含ErrorBoundary包裹)

这种建模能力在重构时尤为明显。我曾让它将一个 Class 组件改写为 Hooks 组件,它不仅完成了语法转换,还自动引入了项目中已有的useRequest(团队封装的请求 Hook),而非生成原生useEffect+fetch的代码。更意外的是,它检测到该组件依赖的@/components/Button已在 2 周前升级为 v2 版本,生成的代码中直接使用了新版本的variant属性。

其背后的逻辑是多层级上下文融合:先解析文件内容建立语法树,再通过文件名、路径推断模块关系,最后结合代码提交记录识别团队编码习惯。这种能力让 AI 生成的代码从 “正确的代码” 变成 “符合团队规范的代码”。

三、实战场景:在复杂业务中验证工具的能力边界

在处理真实业务场景时,Claude Code 的表现呈现出明显的 “能力梯度”—— 对结构化任务(如 API 封装、测试生成)的支持远超非结构化任务(如 UI 交互设计)。

1. 接口层开发:从文档到代码的无缝转换

当后端提供 OpenAPI 文档后,用claude api -i openapi.json -o @/services可直接生成 TypeScript 类型定义和请求函数。它会自动处理:

- 路径参数与查询参数的类型区分(如GET /users/{id}中id必传)

- 响应体的错误类型定义(如401对应UnauthorizedError)

- 请求头的默认配置(如自动添加Authorization字段)

在一个支付系统对接中,它甚至能根据文档中的 “金额字段需保留两位小数” 描述,自动在请求函数中加入toFixed(2)处理,这比单纯的类型生成更贴近业务需求。

2. 性能优化:从 “代码生成” 到 “瓶颈诊断”

在优化一个首屏加载缓慢的 React 应用时,我先让 Claude Code 分析 Lighthouse 报告,它输出的优化方案包含:

- 将lodash替换为按需导入的lodash-es(减少 120KB 打包体积)

- 对非首屏图片使用loading=”lazy”(降低初始请求数)

- 用React.memo缓存 3 个频繁重渲染的列表项组件

更关键的是,它生成了一个usePerformanceMonitor Hook,能在开发环境实时监测组件重渲染次数,帮助定位优化效果。这种 “诊断 – 方案 – 验证” 的闭环能力,已经超越了单纯的代码生成工具范畴。

3. 测试编写:从 “覆盖代码” 到 “覆盖场景”

单元测试是 Claude Code 的强项,但需避免 “为覆盖而覆盖” 的陷阱。在生成一个购物车组件的测试时,我发现:

- 基础指令生成的测试仅验证 “组件是否渲染”

- 加入 “需测试添加 / 删除商品、修改数量后总价更新” 的场景描述后,测试用例覆盖了 80% 的业务逻辑

- 再补充 “测试库存不足时的错误提示”,测试就完整覆盖了所有临界条件

它甚至会使用jest.mock模拟 API 请求,生成 “网络错误时显示重试按钮” 的测试场景 —— 这通常是手动编写测试时容易遗漏的点。

四、协作范式:人机协同的最佳实践

经过三个月的实践,我总结出一套 “人机协同开发流程”,将 Claude Code 的效能最大化:

- 需求拆解阶段:人类负责将业务需求拆分为技术任务(如 “用户下单” 拆分为 “表单验证→库存检查→创建订单”),Claude Code 生成每个任务的技术方案备选。

- 代码生成阶段:AI 生成初稿后,人类聚焦于 “逻辑合理性” 审查(如权限校验是否遗漏、边界条件是否覆盖),而非纠结于语法细节。

- 优化迭代阶段:人类提出性能或可读性优化方向(如 “这个循环能否用二分法优化”),AI 负责具体实现并解释优化原理。

- 知识沉淀阶段:将高频指令(如 “生成符合团队规范的 API 请求函数”)保存为指令模板,形成团队共享的 “AI 协作手册”。

这种分工的核心是:人类掌握 “为什么做” 的决策权,AI 负责 “怎么做” 的执行细节,两者形成互补。

结语:工具进化与开发者的能力迁移

Claude Code 的普及正在推动开发者能力结构的迁移 ——”编写代码” 的权重下降,”定义问题、设计方案、验证效果” 的权重上升。就像计算器的发明让数学家更专注于解决数学问题而非计算本身,AI 编程工具正在让开发者从语法细节中解放,更深入地理解业务逻辑与系统架构。

但工具终究是工具。在使用 Claude Code 的过程中,我最深刻的体会是:真正决定代码质量的,依然是开发者对技术本质的理解。当你能清晰描述 “需要什么、为什么需要、要达到什么标准” 时,AI 会成为最得力的助手;反之,它也可能放大你的模糊与混乱。

或许,未来优秀开发者的核心竞争力,将是 “教会 AI 如何更好地帮助自己”—— 这本身就是一种更高阶的编程能力。

暂无评论内容