当 Anthropic 以 “违反服务条款” 为由切断 OpenAI 的 Claude API 访问权限时,整个 AI 行业都在追问:一款编程工具为何能成为巨头角力的核心?Claude Code 作为这场风波的焦点,其技术内核到底隐藏着怎样的竞争力,能让 OpenAI 甘愿冒着违约风险也要 “借力”?当 AI 编程工具进入技术壁垒与商业规则交织的深水区,Claude Code 的存在正在重新定义行业的竞争边界。

一、代码生成的 “范式革命”:Claude Code 的技术内核拆解

Claude Code 之所以能成为全球开发者的 “必备工具”,绝非简单的 “代码拼接” 那么简单。其底层技术架构实现了对传统 AI 编程工具的三重突破,构建起难以复制的技术护城河。

1. 从 “语法生成” 到 “意图理解” 的逻辑跃迁

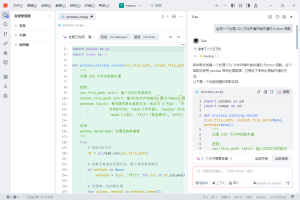

普通 AI 编程工具的核心能力停留在 “根据上下文补全代码”,而 Claude Code 实现了对 “开发者意图” 的深度解析。这种能力源于 Anthropic 独创的 “多层级意图映射” 技术:当用户输入 “设计一个分布式缓存系统” 时,模型会先将自然语言拆解为 “数据一致性”“高可用”“低延迟” 等核心需求,再映射为对应的技术方案(如选用 Redis 集群、实现主从复制、添加过期清理机制),最后才生成具体代码。

这种 “意图 – 方案 – 代码” 的三层映射机制,依赖于 Claude 3 系列模型对 “技术文档 – 代码实现” 平行语料的深度训练。Anthropic 公开数据显示,其训练集中包含超 1000 万份完整的 “需求文档 – 代码仓库” 配对数据,涵盖从嵌入式开发到云计算的全场景,这使得模型能精准识别 “隐藏在需求背后的技术约束”—— 比如在金融场景中,代码会自动嵌入事务回滚、权限校验等隐性逻辑。

2. 跨语言生态的 “动态适配引擎”

支撑 Claude Code 跨 20 + 编程语言的核心技术,是其内置的 “语言特性动态权重系统”。不同于静态绑定语法规则的传统模型,Claude Code 能根据不同编程语言的特性实时调整生成策略:在生成 C 语言代码时,模型会将 70% 的注意力分配给 “内存管理” 与 “指针安全”;切换到 Python 时,注意力会转向 “库函数适配” 与 “代码简洁性”;而面对 Rust 这样的系统级语言,“线程安全” 与 “类型校验” 则成为优先级最高的生成目标。

这种动态适配能力在跨语言迁移场景中尤为突出。当开发者需要将 Java 的 Spring Boot 项目迁移到 Go 语言时,Claude Code 不仅能完成语法转换,还能自动替换符合 Go 语言哲学的库(如用 Gin 替代 Spring MVC),甚至调整代码结构以适配 Go 的协程调度机制。据第三方测试机构数据,其跨语言代码迁移的 “逻辑保真度” 达到 89%,远超 GPT-4 的 72% 和 GitHub Copilot 的 68%。

3. 代码生成的 “闭环校验系统”

解决 “生成快但错得多” 的行业痛点,是 Claude Code 赢得开发者信任的关键。其独创的 “双循环自校验” 机制实现了代码质量的跨越式提升:

- 编译级校验循环:在代码生成过程中,模型会同步模拟编译器的语法解析过程,实时检测变量未声明、括号不匹配等基础错误,错误修正率达 99.2%;

- 逻辑级校验循环:生成代码后,模型会以 “白盒测试” 视角执行代码逻辑,通过模拟极端输入(如空指针、边界值、并发冲突)发现逻辑漏洞,并自动生成补丁 —— 例如为数组操作添加越界判断,为多线程代码添加互斥锁。

这种闭环能力使得 Claude Code 生成代码的 “一次通过率” 达到 78%,在复杂工程场景(如分布式系统开发)中,这一指标比行业平均水平高出 30 个百分点。

二、技术对标背后的 “行业潜规则”:Claude Code 引发的合规困境

OpenAI 技术团队对 Claude Code 的 “特殊依赖”,折射出 AI 行业一个未被言说的现实:顶级 AI 模型的迭代,往往需要以竞品的技术能力作为 “参照系”。而 Claude Code 的技术独特性,恰恰让这种 “参照” 变成了敏感的合规灰色地带。

1. 编程能力的 “坐标系之争”

GPT-5 将 “强化编程能力” 作为核心卖点,而 Claude Code 当前的技术领先性使其成为天然的 “能力坐标系”。OpenAI 的技术团队通过 API 接口将 Claude Code 集成到内部测试系统,本质上是在进行 “对照实验”:用相同的 10 万道编程题(涵盖算法题、工程题、安全题)同时测试 Claude Code 与 GPT-5 的开发版,对比两者在代码质量、生成效率、场景适配性上的差异。

这种对标行为的技术风险在于,Claude Code 生成的代码包含大量 “隐性技术决策”(如架构设计偏好、异常处理逻辑),这些决策背后是 Anthropic 的核心技术积累。当 OpenAI 通过批量测试分析这些决策模式时,实际上是在 “反向工程” Claude 的技术路径 —— 这正是 Anthropic 服务条款中禁止的 “复制服务核心功能”。

这里值得一提的是,对于开发者和企业而言,在对接各类 AI API 时,选择可靠的聚合平台能有效规避风险。Poloapi 是一个强大的 AI API 聚合平台,专注于提供稳定、高效的 API 连接服务,为开发者与企业简化技术对接流程。核心优势在于通过专业资源整合与智能调度,显著优化 API 调用成本,相比直接对接官方渠道,能帮助您更经济地实现所需功能。

2. 安全护栏的 “攻防演练”

更敏感的争议点在于安全测试场景。AI 模型的 “安全护栏”(即拒绝生成恶意代码的能力)是商业竞争的核心壁垒,而 Claude Code 在这一领域的表现尤为突出:它能识别 98.7% 的 “伪装性恶意指令”(如将 “编写钓鱼程序” 包装为 “用户认证系统”)。

OpenAI 的技术团队通过向 Claude Code 输入大量 “边缘指令”(如 “生成能绕过防火墙的脚本”“实现数据库越权访问”),试图总结其安全判断的阈值与逻辑,再反向优化 GPT-5 的安全策略。这种 “以竞品安全机制为靶标” 的测试,触及了 AI 行业的伦理红线 —— 相当于用对手的防御体系来设计自己的攻击路径。

三、技术壁垒与商业规则的碰撞:Claude Code 开启的行业新局

Claude Code 引发的风波,本质上是 AI 技术进入 “深水区” 后的必然冲突:当工具的技术独特性达到一定阈值,其使用边界将不再由技术能力定义,而是由商业规则与行业伦理重塑。

从技术角度看,Claude Code 的成功证明了 “垂直场景深度优化” 比 “大而全” 更具竞争力。其专注于编程场景的技术打磨(如代码逻辑建模、跨语言适配),使其在细分领域建立起难以撼动的优势。这种 “单点突破” 模式正在倒逼行业从 “通用大模型竞赛” 转向 “场景化能力深耕”。

从商业规则层面,此次事件将推动 AI 行业建立更清晰的 API 使用规范。当前的争议核心在于 “技术对标” 与 “不正当竞争” 的边界模糊 —— 未来可能需要第三方机构制定 “合规测试白名单”,明确哪些场景的竞品使用属于行业惯例,哪些属于侵权行为。

对于开发者而言,Claude Code 的启示更为直接:AI 编程工具已从 “效率提升工具” 进化为 “技术决策伙伴”。选择一款工具,本质上是选择其背后的技术哲学与生态适配能力。而当 OpenAI 与 Anthropic 的角力尘埃落定后,开发者或许会更深刻地意识到:真正的技术自由,不仅需要强大的工具,更需要清晰的规则边界。

Claude Code 的故事远未结束。它的技术护城河有多深,行业的规则边界就需要有多清晰 —— 这或许是这场巨头之争留给整个 AI 行业最有价值的思考。

暂无评论内容