![图片[1]-AI大模型成本为何能降低99%?技术突破背后的秘密是什么?](https://sorry.chaofanaigc.com/wp-content/uploads/2025/07/8c7911949e27007f7e6be365638c3e35-1024x768.png)

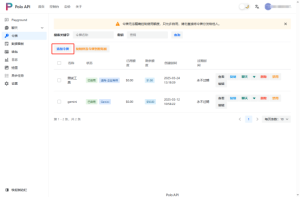

2024年,豆包大模型以0.0008元/千Tokens的定价震撼行业,比同行便宜99.3%。这不仅仅是价格战,更是技术革命的必然结果。从千亿参数规模到万亿Token训练语料,我们正见证着AI大模型从实验室走向大规模商业应用的历史转折点。

关键数据对比:

- 豆包大模型:日均处理1200亿Tokens文本,生成3000万张图片

- 成本突破:0.8厘处理1500个汉字,相当于三本《三国演义》仅需1元

- 应用规模:接入抖音、今日头条等50+业务场景

1. 技术架构优化:效率提升的核心驱动

1.1 Transformer架构的关键突破

注意力机制革命:

- FlashAttention 2.0:内存使用效率提升2-4倍

- 分组查询注意力(GQA):计算复杂度从O(n²)降至O(n)

- 滑动窗口注意力:支持超长上下文处理

位置编码革新:

- RoPE (旋转位置编码):突破传统位置编码长度限制,支持外推到训练时未见过的序列长度

- ALiBi (注意力线性偏置):通过线性衰减机制实现更好的长序列处理

1.2 混合专家模型(MoE)突破

MoE成为2024年降低推理成本的关键技术:

核心优势:

- 总参数量达万亿级别,但单次推理仅激活5-15%

- 专家路由智能选择,确保质量不降低

- 豆包大模型采用该架构实现成本与性能的最佳平衡

2. 训练与推理优化:成本控制的技术密码

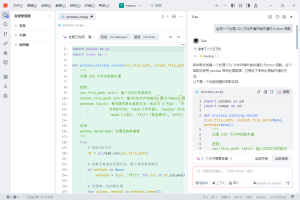

2.1 分布式训练突破

3D并行策略优化:

class EfficientTrainer:

def __init__(self, model, optimizer, gradient_accumulation_steps=8):

self.model = model

self.optimizer = optimizer

self.scaler = GradScaler() # 混合精度训练

self.accumulation_steps = gradient_accumulation_steps

def training_step(self, batch):

with autocast(): # FP16前向传播

loss = self.model(batch) / self.accumulation_steps

# 缩放损失防止梯度下溢

self.scaler.scale(loss).backward()

if (self.step + 1) % self.accumulation_steps == 0:

# 梯度裁剪防止爆炸

self.scaler.unscale_(self.optimizer)

torch.nn.utils.clip_grad_norm_(self.model.parameters(), 1.0)

self.scaler.step(self.optimizer)

self.scaler.update()

self.optimizer.zero_grad()ZeRO优化器状态分片: 通过将优化器状态、梯度和参数分片到不同GPU,ZeRO技术实现了内存使用的线性缩放,使得单台机器能够训练更大规模的模型。

2.2 推理加速核心技术

KV缓存优化:

class OptimizedKVCache:

def __init__(self, max_seq_len, num_heads, head_dim, batch_size):

self.max_seq_len = max_seq_len

# 预分配内存池

self.k_cache = torch.zeros(batch_size, num_heads, max_seq_len, head_dim)

self.v_cache = torch.zeros(batch_size, num_heads, max_seq_len, head_dim)

self.cache_len = torch.zeros(batch_size, dtype=torch.long)

def update_cache(self, new_k, new_v, batch_idx, pos):

"""增量更新KV缓存,避免重复计算"""

seq_len = new_k.size(-2)

self.k_cache[batch_idx, :, pos:pos+seq_len] = new_k

self.v_cache[batch_idx, :, pos:pos+seq_len] = new_v

self.cache_len[batch_idx] = pos + seq_len分布式推理架构: 分布式推理通过将大模型分片到多个GPU上并行执行,实现了超大模型的实时推理。关键技术包括张量并行、流水线并行和动态负载均衡。

3. 应用落地:从技术到商业价值

3.1 垂直领域专业化

医疗大模型:

- 训练数据:医学教科书、论文、病历数据(脱敏)

- 核心能力:疾病诊断、药物推荐、医学影像分析

金融大模型:

- 训练数据:财报、研报、政策文件、市场数据

- 核心能力:风险评估、投资分析、合规检查

3.2 多模态能力突破

豆包大模型的多模态成就:

- 文生图模型:精准的文字理解,擅长中国文化元素创作

- 视频生成:从词曲创作到视频制作的全链路能力

- 语音合成:支持20+方言,具备情感表达能力

视频理解与生成: 通过结合视觉编码器、时序建模和语言理解,现代多模态模型能够理解视频内容并生成相应的文字描述或根据文字生成视频内容。豆包大模型在这方面实现了从词曲创作到视频生成的全链路能力。

3.3 实时交互优化

流式生成技术:

class StreamingGenerator:

def __init__(self, model, tokenizer):

self.model = model

self.tokenizer = tokenizer

def stream_generate(self, prompt, max_length=1000):

"""流式生成,逐token返回结果"""

input_ids = self.tokenizer.encode(prompt, return_tensors='pt')

past_key_values = None

for _ in range(max_length):

with torch.no_grad():

outputs = self.model(

input_ids=input_ids[:, -1:] if past_key_values else input_ids,

past_key_values=past_key_values,

use_cache=True

)

# 获取下一个token

next_token_logits = outputs.logits[0, -1, :]

next_token = torch.argmax(next_token_logits).unsqueeze(0).unsqueeze(0)

# 更新缓存和输入

past_key_values = outputs.past_key_values

input_ids = torch.cat([input_ids, next_token], dim=-1)

# 实时返回token

yield self.tokenizer.decode(next_token[0])4. 商业化突破:成本革命的商业逻辑

4.1 规模效应与技术优化

成本优势来源:

- 技术层面:

- 模型压缩技术降低计算需求

- 专用硬件优化提升效率

- 算法改进减少冗余计算

- 规模层面:

- 硬件采购成本摊薄

- 研发投入规模化分担

- 海量数据训练提升模型效率

- 生态层面:

- 50+业务场景实践验证

- 用户使用量反哺模型优化

- 产业链协同降低整体成本

4.2 商业模式创新

API服务模式: 现代大模型服务通过API形式提供,包含用量跟踪、成本计算、速率限制等核心功能模块,确保服务的稳定性和商业可持续性。

价值创造潜力: 麦肯锡报告显示,到2030年,大模型有望在全球推动49万亿人民币的经济增量。成本降低是推动这一价值实现的关键因素。

5. 未来展望:技术演进与挑战

5.1 技术发展趋势

下一代技术方向:

- 多模态统一:视觉、语音、文本一体化处理

- 实时学习:在线持续学习和适应

- 个性化定制:基于用户偏好的模型微调

- 边缘部署:移动设备上的轻量化模型

AGI系统愿景: 未来的AGI系统将整合感知、推理、规划、记忆和学习等多个模块,形成能够自主处理复杂任务的智能系统。

5.2 挑战与机遇

技术挑战:

- 幻觉问题:生成不准确信息的风险

- 可控性:精确控制输出结果的难度

- 可解释性:决策过程的透明度需求

发展机遇:

- 计算成本持续下降

- 应用场景不断拓展

- 技术生态日趋完善

结语:成本革命背后的技术使命

豆包大模型99%的成本降低,不仅仅是技术优化的结果,更是整个行业从实验室走向产业化的标志。通过架构创新、训练优化、推理加速和应用落地的全链路突破,AI大模型正在实现从”奢侈品”到”必需品”的转变。

面向未来,技术的持续进步将进一步降低AI应用门槛,让更多企业和个人能够享受到AI技术带来的价值。这场成本革命的背后,是无数技术工作者对效率、性能和可用性的不懈追求,也是整个AI产业走向成熟的重要里程碑。

更多AI大模型信息,请关注PoloAPI.com,无论是技术小白还是技术大咖,都能够在这里找到你所要的AI大模型

暂无评论内容