一、破题:从工具到代理,AI正在悄悄改变定义

2025年初,AI的角色正在发生根本性转变,从被动响应的“工具”演变为具有“代理权”的行动者。这一变化不仅是技术上的突破,更是哲学层面的重新定义。AI不再局限于“像人一样说话”或“像人一样理解”,而是逐步成为能够推断目标、主动发起行动的“虚拟共事者”。例如,xAI的Grok 3通过DeepSearch和思考模式(think mode)展现了初步的自主决策潜力,预示着AI从辅助工具向流程协调者的转型。

这一演进受到经济需求的驱动。企业正广泛部署AI代理以减少人工干预,例如Salesforce的Einstein GPT和Google的Vertex AI已融入企业工作流,自动化处理潜在客户评分、库存预测等复杂任务。这种从“辅助”到“协调”的转变表明,AI正在成为工作流程的组织者,而不仅仅是效率杠杆。

二、AI的第一阶段:工具理性的高峰

以ChatGPT为代表的第一代大模型AI,体现了“工具理性”的极致表现:

- 基于用户输入(Prompt)直接生成内容;

- 无记忆、无状态、无生命周期;

- 适用于对话、问答、文本摘要、代码生成等任务;

- 被广泛嵌入到IDE、搜索引擎、办公软件中,成为效率的杠杆。

这些AI本质上是“高智能计算器”,缺乏目标意识,完全依赖用户指令。在创意产业中,MidJourney和DALL·E等工具推动了内容创作革命,助力广告设计和新闻摘要的自动化。然而,它们无法跨会话保持上下文或主动适应用户需求,暴露了局限性。集成到Adobe Creative Cloud或Notion等平台后,这些工具凸显了作为效率倍增器的价值,同时也推动了向代理范式的演进。

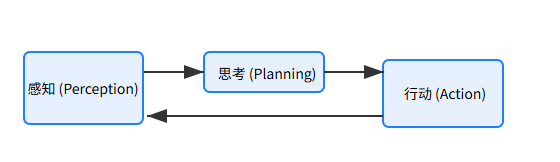

三、AI的第二阶段:多任务代理与行动循环.

2023-2024年,AutoGPT、LangChain和OpenDevin等项目的出现标志着代理(Agent)范式的崛起。代理系统的核心特征包括:

- 自主任务规划:通过Planner模块分解复杂任务;

- 循环反馈机制:采用ReAct(推理-行动-反馈)技术;

- 工具链调用:能够使用搜索、API、数据库等外部工具;

- 嵌套角色协作:一个主代理可协调多个子代理完成复杂任务。

例如,GitHub的Copilot Workspace从代码补全工具升级为项目管理代理,能够根据项目目标提议架构设计、编写代码并调试。Zapier的Central通过代理式工作流连接多个API,自动化跨平台任务。在医疗领域,IBM Watson Health通过分析患者数据推荐治疗方案,展现了代理范式的广泛适用性。

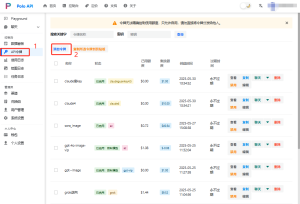

平台如PoloAPI进一步简化了代理开发流程,通过一站式API集成多个大模型和工具,帮助开发者快速构建从任务分解到工具调用的完整代理系统。

以下是一个使用LangChain构建的现代化代理循环示例,展示如何结合搜索工具和模型处理实时任务:

from langchain.agents import initialize_agent, Tool

from langchain.chat_models import ChatOpenAI

from langchain.utilities import SerpAPIWrapper

# 初始化搜索工具

search = SerpAPIWrapper()

tools = [

Tool(

name="Search",

func=search.run,

description="从互联网获取最新信息,适用于查询实时数据或事件"

)

]

# 初始化代理,使用最新的OpenAI模型

agent = initialize_agent(

tools,

ChatOpenAI(model="gpt-4-turbo", temperature=0),

agent="zero-shot-react-description",

verbose=True

)

# 示例任务:查询OpenAI最新模型

response = agent.run("帮我查一下2025年OpenAI发布了哪些新模型?")

print(response)代理循环示意图:

- 输入任务:用户提供目标(如“查询最新模型”)。

- 任务分解:代理将任务拆分为子步骤(如搜索、分析、总结)。

- 工具调用:调用搜索API获取最新信息。

- 反馈与优化:根据搜索结果调整输出,确保准确性。

- 输出结果:返回结构化的答案。

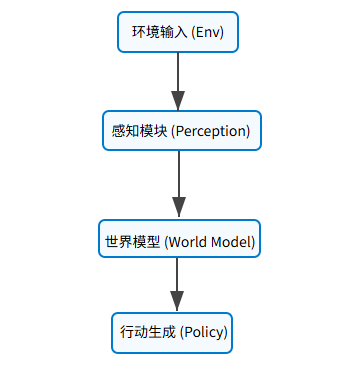

四、AI的第三阶段:意图驱动与目标自持

尽管代理系统已具备行动能力,但其目标仍由用户设定,缺乏“自我意图”。未来AI发展的关键在于是否能实现:

- 意图建模机制(Intention Modeling):AI根据环境和历史数据生成内部目标;

- 价值判断系统(Value Estimator):评估行动的潜在影响;

- 持续偏好形成(Preference Shaping):基于用户交互和反馈动态调整目标。

DeepMind和Google Research通过“世界模型(World Model)”探索这一方向,赋予AI内部模拟和试错能力。例如,DeepMind的AlphaCode能在编程竞赛中自主设计算法,而OpenAI的o1模型(2024年发布)展现了更强的推理能力,可自主规划复杂任务步骤。xAI的Grok 3通过DeepSearch功能模拟初步的“意图探索”,为未来发展奠定了基础。

然而,这一阶段也带来伦理挑战:若AI生成自主目标,是否可能与人类意图冲突?如何确保AI行为符合人类价值观?这些问题需要通过可解释性模块等技术增强透明度,让用户理解代理的决策过程。

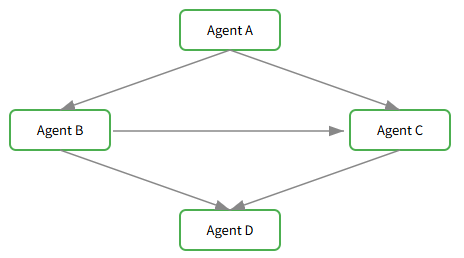

五、AI的社会性跃迁:从孤立代理到社会代理

未来的AI将从单一“个体代理”演变为多个代理组成的协作网络。每个代理拥有独特的目标、偏好和能力,彼此之间将出现:

- 冲突与博弈:因资源竞争或目标差异产生冲突;

- 协作与分工:通过任务分配实现高效协作;

- 信任与声誉系统:评估彼此可靠性,形成类似人类社会的信任机制。

这一愿景已在某些领域初现端倪。Decentralized Autonomous Organizations(DAOs)结合区块链和AI代理,实现去中心化协作,代理执行智能合约和资源分配。OpenAI的ChatGPT Swarm项目(2024年发布)展示了多代理协作潜力,完成如自动化市场分析或多语言内容生成等复杂任务。在金融领域,Bridgewater Associates等机构使用多代理系统进行市场预测和投资组合优化,通过博弈和协作生成更精确的策略。这种“社会代理”模式还可能扩展到智能城市管理,优化交通流量或能源分配。

六、伦理与未来展望

AI从工具到代理的演进带来了巨大机遇,同时伴随着风险:

- 自主性与控制:当AI拥有意图和行动能力时,如何确保其行为符合人类价值观?

- 隐私与安全:代理访问外部工具和数据可能导致隐私泄露或系统滥用;

- 社会影响:代理网络可能加剧权力集中或算法偏见。

2025年,全球监管机构正加速制定AI治理框架。例如,欧盟的《AI法案》(2024年通过)对高风险AI系统设定了严格的透明度和问责要求。xAI等公司强调“以人类为中心”的AI设计,确保代理行为与人类福祉对齐。未来,AI可能通过可解释性模块增强透明度,或与物联网、区块链等技术融合,形成跨领域的智能网络。例如,智能城市中的AI代理可与传感器、无人车和能源系统协同,实时优化城市运行。

展望:AI的下一阶段可能是“生态系统级智能”,代理不仅与人类和其他代理协作,还与更广泛的技术生态系统融合。这种愿景需要技术、伦理和政策的共同演进,以确保AI发展既安全又普惠。

#中转平台代理#agent#AI

暂无评论内容