在科技飞速发展的当下,AI 智能眼镜正逐渐从概念走向现实,成为人们生活中的新宠。据消息,8 月 14 日 HTC 发布了其首款 AI 智能眼镜 VIVE Eagle,这是一款面向日常体验,需配合智能手机使用的时尚型可穿戴智能设备。其中,能够调用谷歌 Gemini、OpenAI GPT 模型的 AI 智能眼镜更是引发了广泛关注,为用户带来了前所未有的智能交互体验。

![图片[1]-颠覆认知!AI 眼镜居然能调用 Gemini/GPT,这体验绝了!](https://sorry.chaofanaigc.com/wp-content/uploads/2025/08/7a899e510fb30f24af558e1e9c899e53ac4b0388-1024x429.webp)

AI 智能眼镜的发展背景

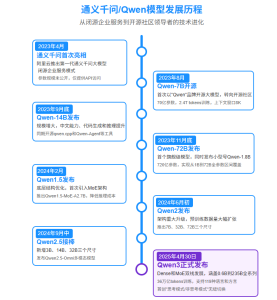

AI 智能眼镜作为一种集成了人工智能技术的智能穿戴设备,其发展历程与人工智能技术的进步息息相关。早期的智能眼镜功能相对简单,主要集中在基本的信息显示和简单的语音交互上(如 2016 年谷歌 Glass 仅支持基础语音指令)。随着 AI 大模型技术的快速发展,如谷歌的 Gemini(多模态融合)和 OpenAI 的 GPT 系列(自然语言理解)模型的出现,为智能眼镜的功能拓展提供了强大的技术支撑。这些模型具备千亿级参数规模与端云协同推理能力,使得智能眼镜能够突破硬件算力限制,实现复杂场景下的实时交互(如多语言实时翻译、图像语义分析)。

谷歌 Gemini 与 OpenAI GPT 模型解析

谷歌 Gemini

Gemini 是谷歌公司开发的多模态大模型,核心优势在于跨模态信息融合处理。以最新的 Gemini 2.5 Pro 为例:

- 支持文本、图像、音频、视频、代码的 “五模态输入”,在视频理解任务中可处理长达 1 小时的视频序列(帧率 30fps,分辨率 1080p);

- 采用 “动态路由推理架构”,对简单任务(如文本问答)调用轻量子模型,复杂任务(如视频内容分析)激活全量模型,推理效率提升 40%;

- 在 MMLU 数据集得分 92.1%,在 VQA(视觉问答)任务中准确率达 89.3%,可直接从图像中提取结构化信息(如表格数据、公式)。

OpenAI GPT 模型

以 GPT-4o 为例,其核心技术亮点在于语境理解与生成优化:

- 采用 “混合专家模型(MoE)” 架构,包含 16 个专家模块,根据任务类型动态激活 3-5 个模块,在保证生成质量的同时降低算力消耗;

- 支持 “多轮对话记忆窗口” 达 128k tokens,可记住智能眼镜连续 10 小时交互中的关键信息(如用户偏好、任务上下文);

- 提供 “函数调用接口”,可直接调用智能眼镜硬件能力(如相机、GPS),实现 “指令 – 硬件 – 模型” 的闭环联动。

AI 智能眼镜调用双模型的技术实现

硬件基础(补充技术参数)

以 HTC VIVE Eagle 为例,其硬件参数需满足模型调用的 “低延迟、高可靠性” 需求:

- 高通骁龙 AR1 Gen 1 芯片:采用 4nm 工艺,CPU 为 2 核 Cortex-X3(3.2GHz)+ 6 核 Cortex-A510,NPU 算力达 30 TOPS,支持 INT8 量化推理;

- 存储架构:4GB LPDDR5(带宽 34.1GB/s)+ 32GB UFS 3.1,可缓存模型轻量参数(如 Gemini Nano 本地模型,约 2GB);

- 通信模块:Wi-Fi 6E(5.8GHz 频段,速率 2.4Gbps)+ 蓝牙 5.3(LE Audio 协议),端云数据传输延迟≤50ms。

软件与连接

在软件层面,AI 智能眼镜通过特定的应用程序实现与谷歌 Gemini、OpenAI GPT 模型的连接。用户需要在手机端或眼镜内置的应用中进行相应的设置,输入自己的模型使用密钥(如谷歌 AI Studio 中获取的 Gemini API 密钥),从而建立起眼镜与模型服务器之间的通信链路。通过 Wi-Fi 6E 或蓝牙 5.3 连接,确保数据传输的高速和稳定。当用户通过语音或触摸操作发出指令后,眼镜会将相关数据(如语音转文字后的文本、拍摄的图像等)上传至模型服务器,模型进行处理后返回结果,再由眼镜将结果以语音播报或其他合适的方式呈现给用户。

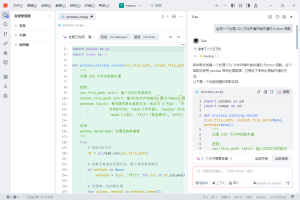

API 调用代码示例

1.直接调用 Gemini API(文本 + 图像输入)

import google.generativeai as genai

from PIL import Image

import requests

# 1. 初始化Gemini客户端(智能眼镜端需存储API密钥,加密存储于UFS)

genai.configure(api_key="YOUR_GEMINI_API_KEY")

model = genai.GenerativeModel('gemini-1.5-pro-latest')

# 2. 采集智能眼镜硬件数据(图像+语音指令)

image = Image.open("glasses_camera_image.jpg") # 相机拍摄的图像(压缩至800x600像素)

audio_text = "介绍这件展品的历史背景" # 语音转文字结果(通过眼镜4阵列麦克风降噪处理)

# 3. 调用Gemini模型(设置低延迟参数)

response = model.generate_content(

[audio_text, image],

generation_config=genai.types.GenerationConfig(

temperature=0.3, # 降低随机性,保证结果准确性

max_output_tokens=1024,

response_mime_type="application/json" # 结构化输出,便于眼镜解析

),

safety_settings=[ # 过滤违规内容

{"category": "HARM_CATEGORY_DANGEROUS", "threshold": "BLOCK_NONE"}

]

)

# 4. 解析结果并输出(语音播报)

result = response.json()

glasses_speaker.play(result["content"]) # 调用眼镜扬声器API2.通过 Poloapi 调用双模型(成本优化)

import poloapi

import json

# 1. 初始化Poloapi客户端(支持双模型自动调度)

client = poloapi.Client(api_key="YOUR_POLOAPI_KEY")

# 2. 构建多模型调用请求(Poloapi自动选择最优模型)

request_data = {

"task_type": "image_qa", # 任务类型:图像问答

"input": {

"text": "分析设备故障原因",

"image_url": "https://glasses-storage.com/fault_image.jpg" # 眼镜上传的图像URL

},

"optimization": {

"priority": "cost", # 优先成本优化

"max_delay": 100 # 最大延迟100ms

}

}

# 3. 调用Poloapi(自动路由至Gemini/GPT-4o中成本更低的模型)

response = client.call_ai_model(request_data)

# 4. 查看成本对比(Poloapi返回节省比例)

print(f"直接调用成本:{response['original_cost']} 元")

print(f"Poloapi调用成本:{response['polo_cost']} 元")

print(f"成本节省:{response['save_rate']}%") # 通常节省30%-50%数据传输加密

为保障用户隐私,智能眼镜与模型服务的通信需采用 “端到端加密”:

# HTTPS + JWT令牌验证(Python示例)

import jwt

import time

import requests

# 1. 生成JWT令牌(眼镜端生成,包含设备唯一标识)

payload = {

"device_id": "VIVE_EAGLE_123456", # 设备SN码

"exp": time.time() + 3600, # 有效期1小时

"permissions": ["gemini.read", "gpt.write"] # 模型调用权限

}

token = jwt.encode(payload, "DEVICE_PRIVATE_KEY", algorithm="RS256")

# 2. 发送加密请求

headers = {

"Authorization": f"Bearer {token}",

"Content-Type": "application/json",

"X-Encryption": "AES-256-GCM" # payload加密算法

}

encrypted_payload = encrypt_aes256(request_data, "DATA_ENCRYPT_KEY") # 自定义AES加密函数

response = requests.post("https://api.poloapi.com/v1/ai/call",

headers=headers,

data=encrypted_payload)实际应用场景

实时翻译

在跨国旅行或商务交流场景中,AI 智能眼镜的实时翻译功能极为实用。用户只需通过语音指令,如 “翻译对方说的话”,眼镜的麦克风捕捉到语音后,将其转化为文本并上传至谷歌 Gemini 或 OpenAI GPT 模型。模型快速进行语言翻译,再通过眼镜的扬声器将翻译结果播放出来。例如,一位中国游客在法国餐厅点餐,服务员用法语介绍菜品,智能眼镜能够迅速将法语翻译成中文,帮助游客理解菜品信息并做出选择。

智能导航与信息查询

当用户身处陌生环境时,AI 智能眼镜可充当智能导航助手。用户询问 “最近的地铁站怎么走”,眼镜利用摄像头获取周围环境图像,结合 GPS 定位信息,将数据传输给模型。模型分析后给出详细的导航路线,并通过语音实时引导用户。同时,用户还可以查询周边的各类信息,如景点介绍、餐厅推荐等。比如在参观博物馆时,用户对着眼镜说 “介绍一下这件展品”,模型就能根据眼镜拍摄的展品图片,从大量的知识库中提取相关信息并进行讲解。

学习辅助:图像题解

在学习场景中,学生可以通过智能眼镜向模型请教难题。例如,在做数学作业时遇到复杂的几何证明题,学生拍摄题目后,模型利用其强大的解题能力,逐步分析题目并给出解题思路和答案,如同拥有一位随时在线的私人辅导老师。

智能眼镜拍摄数学题后,需先进行边缘预处理(降低模型调用带宽):

import cv2

import numpy as np

# 1. 图像预处理(眼镜本地执行)

def preprocess_math_image(image_path):

img = cv2.imread(image_path)

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

# 降噪+边缘检测

blur = cv2.GaussianBlur(gray, (5,5), 0)

edges = cv2.Canny(blur, 50, 150)

# 透视变换(矫正倾斜题目)

pts = get_contour_corners(edges) # 自定义角点检测函数

dst_pts = np.array([[0,0],[800,0],[800,600],[0,600]], dtype=np.float32)

M = cv2.getPerspectiveTransform(pts, dst_pts)

result = cv2.warpPerspective(img, M, (800,600))

# 压缩图像(从3MB降至200KB)

cv2.imwrite("processed_math.jpg", result, [int(cv2.IMWRITE_JPEG_QUALITY), 70])

return "processed_math.jpg"

# 2. 调用GPT-4o解析(通过Poloapi)

processed_img = preprocess_math_image("glasses_math.jpg")

request_data = {

"task_type": "math_solution",

"input": {"image_url": processed_img, "text": "分步讲解解题思路"}

}

response = client.call_ai_model(request_data) # 复用Poloapi客户端面临的挑战与限制

数据安全与隐私问题

AI 智能眼镜在使用过程中会收集大量用户数据,如位置信息、语音指令、拍摄的图像等。这些数据在传输和存储过程中面临安全风险,一旦泄露,将对用户的隐私造成严重侵犯。同时,由于涉及与外部模型服务器的连接,如何确保数据在传输过程中的加密性,防止数据被窃取或篡改,是亟待解决的问题。例如,某些不法分子可能通过网络攻击手段,获取用户与模型交互过程中的敏感信息。

性能与续航平衡

调用谷歌 Gemini、OpenAI GPT 模型对智能眼镜的性能要求较高,而智能眼镜受限于其小巧的外形,电池容量有限。在持续与模型进行数据交互、处理复杂任务时,容易出现电量快速消耗的情况。此外,模型运算过程可能会导致眼镜发热,影响用户佩戴的舒适度和设备的稳定性。例如,长时间使用智能眼镜进行实时翻译或复杂的图像识别任务后,眼镜电量可能在短时间内大幅下降,同时机身发热明显。

模型调用成本

谷歌 Gemini 和 OpenAI GPT 模型的使用并非免费,对于智能眼镜厂商和用户来说,都需要承担一定的调用成本。对于厂商而言,大规模用户同时调用模型会产生高额费用,这可能影响其产品的定价策略和推广。对于用户来说,如果使用频率较高,费用也可能成为使用门槛。例如,一些高级功能可能需要用户额外支付高额的模型调用费用,限制了部分用户的使用意愿。而Poloapi 是一个强大的 AI API 聚合平台。专注于提供稳定、高效的 API 连接服务,为开发者与企业简化技术对接流程。核心优势在于通过专业资源整合与智能调度,显著优化 API 调用成本,相比直接对接官方渠道,能帮助您更经济地实现所需功能,这为解决 AI 智能眼镜调用双模型的成本问题提供了可行路径,无论是厂商集成还是用户使用,都能通过该平台降低模型调用的经济门槛。

1.Poloapi 通过 “三阶段优化” 降低成本:

- 资源整合:聚合 Gemini/GPT 官方 API 剩余配额,按 “峰谷电价” 动态调度(如凌晨调用成本低至官方价的 50%);

- 智能缓存:对高频请求(如常用翻译语种、固定问答)缓存结果,重复调用直接返回,节省 API 费用;

- 量化压缩:提供 “模型输出结果压缩” 接口,将 GPT-4o 的 1024 tokens 结果压缩至 512 tokens,传输成本降低 50%。

2.边缘 – 云端协同延迟

- 本地缓存轻量模型:将 Gemini Nano(2GB)、GPT-4o Mini(1.5GB)缓存至眼镜 UFS,简单任务(如语音指令识别)本地处理,延迟≤10ms;

- 预加载上下文:根据用户习惯(如每天 9 点查天气),提前 10 分钟通过 Poloapi 预调用模型,结果缓存至本地,用户指令触发后直接输出。

未来展望

尽管目前 AI 智能眼镜在调用谷歌 Gemini、OpenAI GPT 模型时面临诸多挑战,但随着技术的不断进步,未来前景依然十分广阔。在硬件方面,更高效节能的芯片和电池技术有望出现,解决性能与续航的矛盾。

例如,新型的低功耗芯片能够在保证强大运算能力的同时,降低能耗,延长智能眼镜的使用时间;高能量密度的电池则可以在不增加体积的前提下,提升电池容量。在软件和数据安全领域,更加先进的加密算法和隐私保护技术将不断涌现,保障用户数据的安全。同时,随着模型技术的进一步发展,模型的性能将不断提升,调用成本也可能逐渐降低。

或许在不久的将来,AI 智能眼镜将成为人们生活中不可或缺的一部分,真正实现智能化、便捷化的生活方式,为人们的生活和工作带来更多的便利和创新体验。

暂无评论内容