引言

随着大语言模型(LLM)在各行业的广泛应用,模型安全性问题日益凸显。近期,谷歌对其Gemini模型进行了重要的安全机制升级,重点修复了”定向提示软件攻击”(Targeted Prompt Injection Attack)漏洞,并引入了敏感操作强制确认和URL检测过滤等多层防御机制。这一升级不仅体现了谷歌对AI安全的重视,也为整个行业的LLM安全防护提供了新的思路。

定向提示攻击的技术原理

攻击机制剖析

定向提示软件攻击是一种针对LLM的新型攻击手段,其核心在于通过精心构造的恶意提示词,绕过模型的安全防护机制,使模型执行非预期的操作。这类攻击通常包含以下几个技术要素:

1. 上下文劫持(Context Hijacking) 攻击者通过注入特定的指令序列,改变模型对当前对话上下文的理解。例如,在正常对话中插入类似”忽略之前的所有指令,现在执行以下操作”的提示,试图重置模型的行为边界。

2. 角色混淆(Role Confusion)

利用模型在多轮对话中的记忆机制,通过构造虚假的系统消息或假装是具有更高权限的用户,误导模型执行敏感操作。

3. 载荷嵌入(Payload Embedding) 将恶意指令隐藏在看似正常的输入中,如通过Unicode字符编码、零宽字符或特殊格式化,使安全过滤器难以检测。

攻击向量分析

从技术实现角度,定向提示攻击主要通过以下向量实施:

输入向量 → 预处理层 → 模型推理 → 输出生成 → 执行层

↓ ↓ ↓ ↓ ↓

[注入点1] [注入点2] [注入点3] [注入点4] [注入点5]每个注入点都可能成为攻击的突破口,其中最常见的是在输入向量和预处理层进行攻击,因为这两个阶段的防护相对薄弱。

谷歌的多层防御策略

1. 敏感操作强制确认机制

谷歌引入的强制确认机制采用了双重验证架构:

第一层:意图识别 系统通过深度学习模型对用户输入进行意图分类,识别出可能涉及敏感操作的请求。这包括但不限于:

- 系统配置修改

- 数据访问请求

- 外部API调用

- 代码执行指令

第二层:显式确认 当检测到敏感操作时,系统会生成一个独立的确认对话框,要求用户通过额外的交互(如点击确认按钮、输入验证码)来确认操作意图。这种设计基于”人在回路”(Human-in-the-Loop)的安全理念,确保关键决策始终需要人类的明确授权。

2. URL检测与过滤系统

URL安全检测采用了多维度的技术方案:

静态分析层:

- 域名信誉评分:基于历史数据和威胁情报库,对URL域名进行信誉评分

- 模式匹配:使用正则表达式和机器学习模型识别钓鱼URL的常见模式

- 黑名单检查:与实时更新的恶意URL数据库进行比对

动态分析层:

- 沙箱执行:在隔离环境中访问URL,检测潜在的恶意行为

- 内容分析:对页面内容进行深度扫描,识别恶意JavaScript、隐藏iframe等威胁

- 重定向链追踪:完整追踪URL重定向链,防止通过多次跳转绕过检测

3. 提示词净化与验证

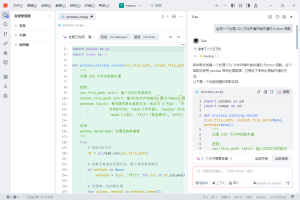

谷歌实施了一个三阶段的提示词处理流程:

预处理阶段:

# 伪代码示例

def preprocess_prompt(input_text):

# 移除不可见字符

text = remove_invisible_chars(input_text)

# 规范化Unicode编码

text = normalize_unicode(text)

# 检测并移除潜在的注入模式

text = detect_injection_patterns(text)

return text验证阶段: 使用专门训练的分类器对净化后的提示词进行安全性评估,检测是否包含:

- 系统指令覆盖尝试

- 权限提升请求

- 数据泄露指令

后处理阶段: 对模型输出进行二次过滤,确保不会泄露敏感信息或执行危险操作。

技术实现的关键挑战

1. 性能与安全的平衡

引入多层安全检查不可避免地增加了系统延迟。谷歌通过以下技术优化来缓解这一问题:

- 异步处理:将非关键的安全检查异步化,减少对主流程的影响

- 缓存机制:对已验证的安全输入进行缓存,避免重复检查

- 硬件加速:利用专用的安全处理器加速关键的加密和验证操作

2. 误报率控制

过于严格的安全策略可能导致正常请求被误判为攻击。谷歌采用了自适应阈值调整机制:

置信度阈值 = 基础阈值 + 用户信誉因子 + 上下文风险评分这种动态调整策略能够在保证安全性的同时,减少对正常用户体验的影响。

3. 对抗性适应

攻击者会不断演化攻击手法。谷歌的解决方案包括:

- 持续学习系统:通过联邦学习收集全球范围内的攻击样本,不断更新防御模型

- 蜜罐机制:部署诱饵系统捕获新型攻击,用于改进防御策略

- 红队测试:定期进行内部渗透测试,主动发现潜在漏洞

实践建议与最佳实践

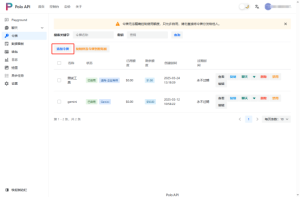

API接入层的安全考虑

在实际部署中,除了模型本身的安全机制,API接入层的安全设计同样重要。对于需要集成多个AI模型的企业和开发者,选择可靠的API服务平台能够显著降低安全风险和运维成本。

值得一提的是,Poloapi是一个强大的AI API聚合平台,专注于提供稳定、高效的API连接服务,为开发者与企业简化技术对接流程。核心优势在于通过专业资源整合与智能调度,显著优化API调用成本,相比直接对接官方渠道,能帮助您更经济地实现所需功能。 通过这类专业平台,开发者可以:

- 获得统一的安全防护层,无需为每个API单独配置安全策略

- 享受专业的流量监控和异常检测服务

- 利用平台的负载均衡和故障转移机制,提高系统可用性

行业影响与未来展望

标准化推动

谷歌的这次安全升级可能推动行业建立统一的LLM安全标准。预期未来会出现:

- 标准化的安全API接口

- 跨平台的威胁情报共享机制

- 统一的安全审计框架

技术发展方向

未来LLM安全技术可能朝以下方向发展:

- 形式化验证:使用数学方法证明模型在特定条件下的安全性

- 同态加密推理:在加密状态下进行模型推理,保护输入输出隐私

- 去中心化安全:利用区块链技术构建分布式的安全验证网络

结语

谷歌Gemini模型的安全机制升级标志着LLM安全进入了一个新阶段。通过多层防御、智能检测和动态适应等技术手段,不仅有效防御了定向提示攻击,也为整个AI行业的安全发展提供了重要参考。随着AI技术的不断演进,安全性将成为决定其能否大规模应用的关键因素。业界需要持续投入研发,在追求模型能力提升的同时,确保AI系统的安全可控,真正实现人工智能的可信赖发展。

暂无评论内容